Python高级技巧:用一行代码减少一半内存占用

翻译 | 邓普斯•杰弗

校对 | 酱番梨 整理 | 菠萝妹

原文链接:@alexmaisiura/python-how-to-reduce-memory-consumption-by-half-by-adding-just-one-line-of-code-56be6443d524

我想与大家分享一些我和我的团队在一个项目中经历的一些问题。在这个项目中,我们必须要存储和处理一个相当大的动态列表。测试人员在测试过程中,抱怨内存不足。下面介绍一个简单的方法,通过添加一行代码来解决这个问题。

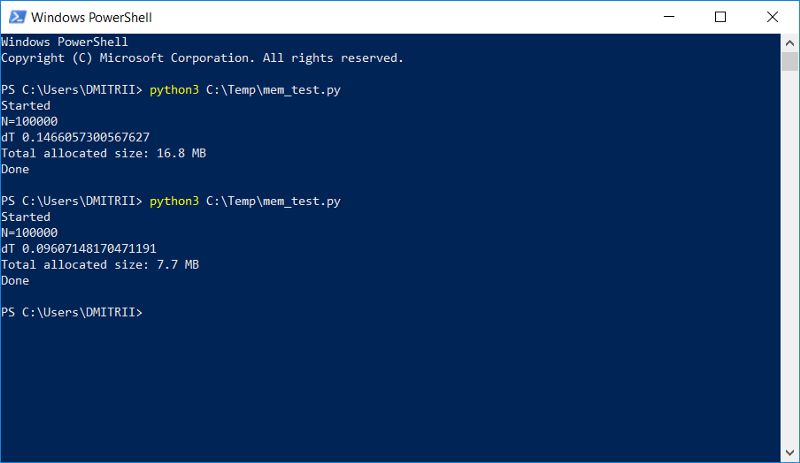

图片的结果

下面我来解释一下,它是如何运行的。

首先,我们考虑一个简单的"learning"例子,创建一个Dataltem 类,该类是一个人的个人信息,例如姓名,年龄,地址等。

class DataItem(object):

def __init__(self, name, age, address):

self.name = name

self.age = age

self.address = address

初学者的问题:如何知道一个以上这样的对象占用多少内存?

首先,让我们试着解决一下:

d1 = DataItem("Alex", 42, "-")

print ("sys.getsizeof(d1):", sys.getsizeof(d1))

我们得到的答案是56bytes,这似乎占用了很少的内存,相当满意喽。那么,我们在尝试另一个包含更多数据的对象例子:

d2 = DataItem("Boris", 24, "In the middle of nowhere")

print ("sys.getsizeof(d2):", sys.getsizeof(d2))

答案仍然是56bytes,此刻,似乎我们意识到哪里有些不对?并不是所有的事情都第一眼所见那样。

直觉不会让我们失望,一切都不是那么简单。Python是一种具有动态类型的非常灵活的语言,对于它的工作,它存储了大量的附加数据。它们本身占据了很多。

例如,sys.getsizeof("")返回33bytes,是的一个多达33个字节的空行!并且sys.getsizeof(1)返回24bytes,一个整个数字占用24个bytes(我想咨询C语言程序员,远离屏幕,不想在进一步阅读,以免对美观失去信心)。对于更复杂的元素,如字典,sys.getsizeof(.())返回272字节,这是针对空字典的,我不会再继续了,我希望原理是明确的,并且RAM的制造商需要出售他们的芯片。

但是,我们回到我们的DataItem类和最初的初学者的疑惑。

这个类,占多少内存?

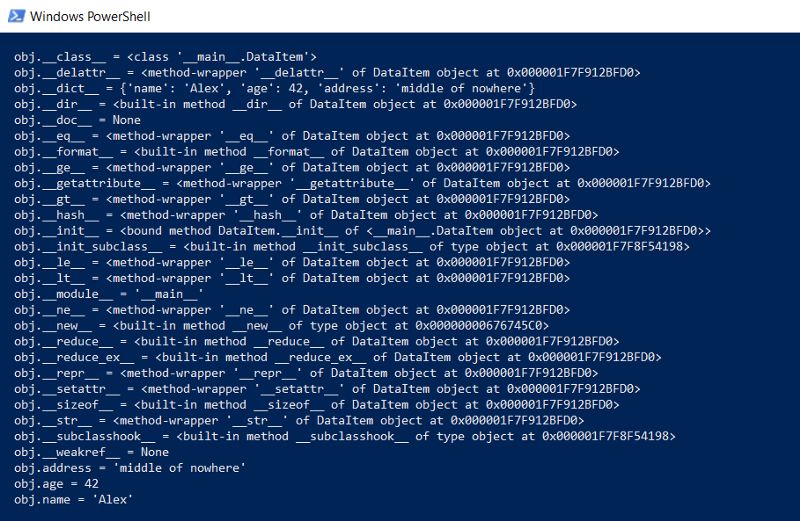

首先,我们一小写的形式将这个类的完整内容输出:

def dump(obj):

for attr in dir(obj):

print(" obj.%s = %r" % (attr, getattr(obj, attr)))

这个函数将显示隐藏的“幕后”使所有Python函数(类型、继承和其他内容)都能够正常工作的内容。

结果令人印象深刻:

这一切内容占用多少内存?

下边有一个函数可以通过递归的方式,调用getsizeof函数,计算对象实际数据量。

def get_size(obj, seen=None):

# From

# Recursively finds size of objects

size = sys.getsizeof(obj)

if seen is None:

seen = set()

obj_id = id(obj)

if obj_id in seen:

return 0

# Important mark as seen *before* entering recursion to gracefully handle

# self-referential objects

seen.add(obj_id)

if isinstance(obj, dict):

size += sum([get_size(v, seen) for v in obj.values()])

size += sum([get_size(k, seen) for k in obj.keys()])

elif hasattr(obj, '__dict__'):

size += get_size(obj.__dict__, seen)

elif hasattr(obj, '__iter__') and not isinstance(obj, (str, bytes, bytearray)):

size += sum([get_size(i, seen) for i in obj])

return size

让我们试一试:

d1 = DataItem("Alex", 42, "-")

print ("get_size(d1):", get_size(d1))

d2 = DataItem("Boris", 24, "In the middle of nowhere")

print ("get_size(d2):", get_size(d2))

我们获得的答案分别为460bytes和484bytes,这结果似乎是真实的。

使用这个函数,你可以进行一系列的实验。例如,我想知道如果DataItem结构放在列表中,数据将占用多少空间。get_size ([d1])函数返回532bytes,显然,这与上面说的460+的开销相同。但是get_size ([d1, d2])返回863bytes,小于以上的460 + 484。get_size ([d1, d2, d1])的结果更有趣——我们得到了871字节,只是稍微多一点,也就是说Python足够聪明,不会再次为同一个对象分配内存。

现在,我们来看一看问题的第二部分。

是否存在减少内存开销的可能呢?

是的,可以的。Python是一个解释器,我们可以在任何时候扩展我们的类,例如,添加一个新的字段:

d1 = DataItem("Alex", 42, "-")

print ("get_size(d1):", get_size(d1))

d1.weight = 66

print ("get_size(d1):", get_size(d1))

非常好,但是如果我们不需要这个功能呢?我们能强制解释器来指定类的列表对象使用__slots__命令:

版权保护: 本文由 沃派博客-沃派网 编辑,转载请保留链接: http://www.bdice.cn/html/6869.html